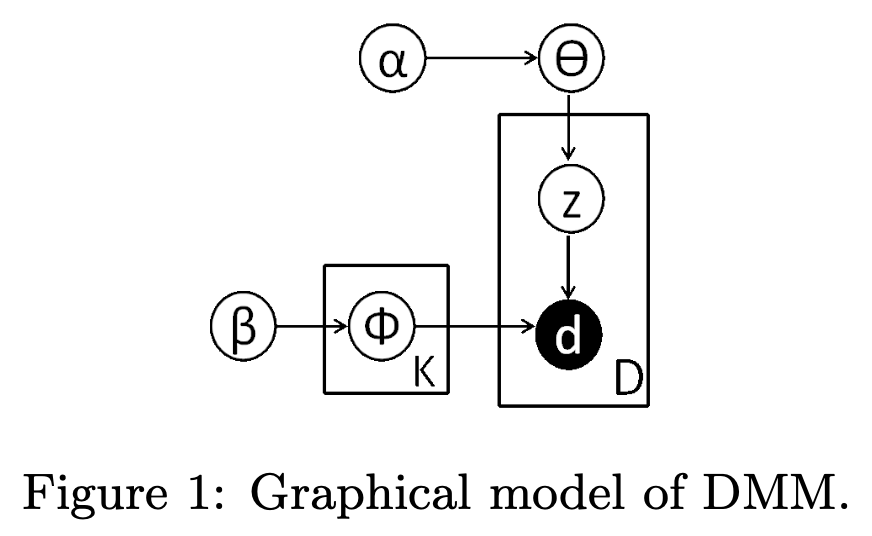

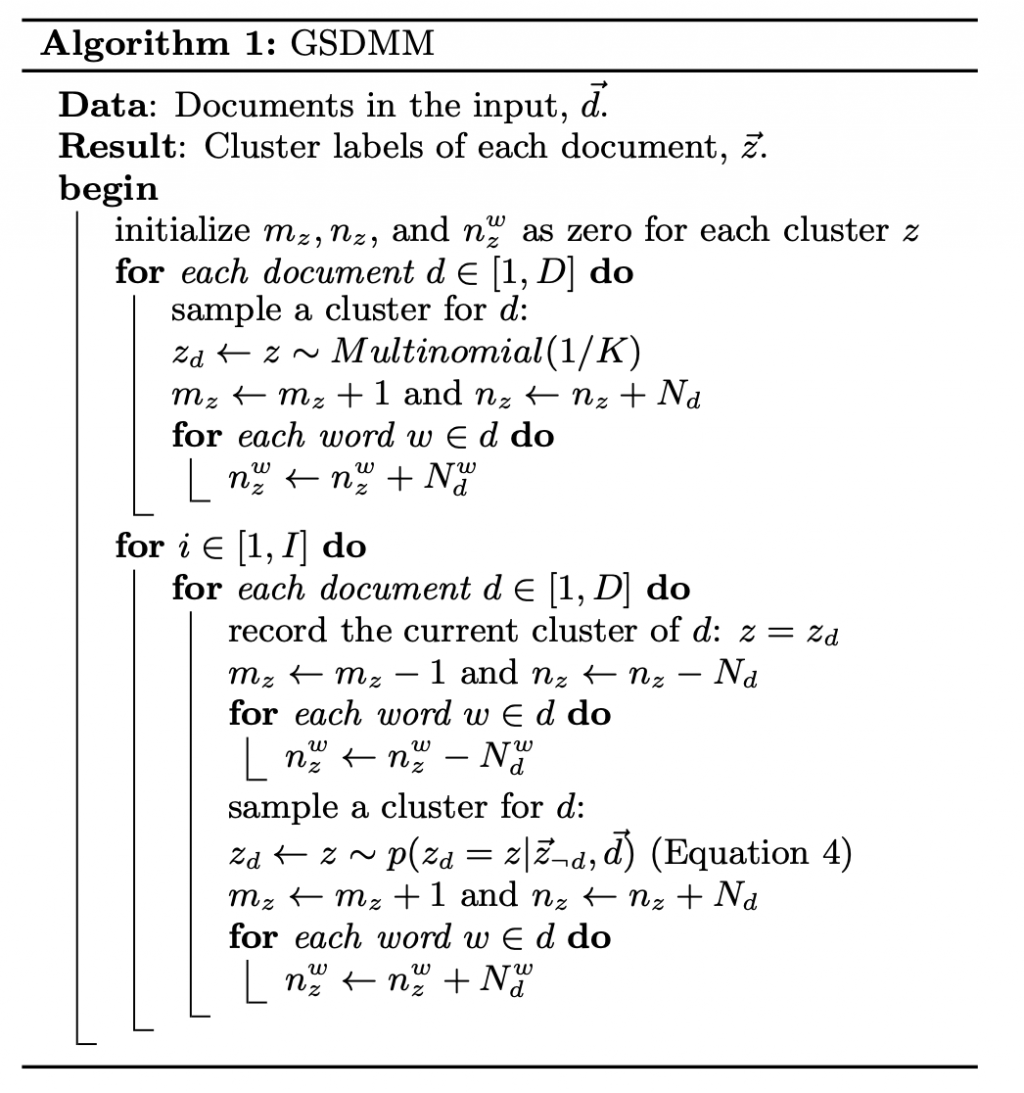

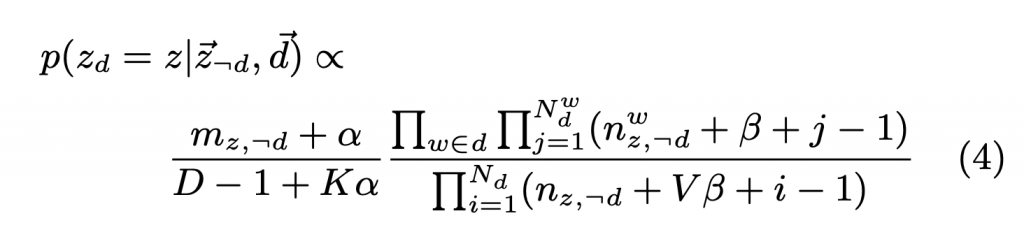

此文為了短文本分群提出一個機率圖模型,並為之提出一個 collapsed Gibbs Sampling 演算法,並另外提出一個類比情境,稱作電影小組過程,方便讀者理解模型。其優勢在於可以自動決定群數量,在效能表現上也優於 KMeans、HAC、DMAFP。在後續的實驗中,也對模型的兩個參數做了質性分析。

KDD 2014

Yin and Wang 2014

https://www.semanticscholar.org/paper/A-dirichlet-multinomial-mixture-model-based-for-Yin-Wang/d03ca28403da15e75bc3e90c21eab44031257e80?p2df

[未完待續]